运行大型语言模型(LLM)如ChatGPT和Claude通常需要将数据发送到由OpenAI和其他AI模型提供商管理的服务器。虽然这些服务是安全的,但一些企业为了更高的隐私保护,倾向于将数据完全离线保存。

本文将介绍六款开发者可以用于本地运行和测试LLM的工具,这些工具确保数据不会离开本地设备,类似于端到端加密对隐私的保护方式。

为什么要使用本地LLM?

像LM Studio这样的工具不收集用户数据或追踪用户操作,允许所有聊天数据保存在本地机器上,而不与AI/ML服务器共享。

- 隐私:可以在本地主机上多轮交互,而不需要担心数据离开设备。

- 自定义选项:本地LLM提供了高级配置选项,如CPU线程、温度、上下文长度、GPU设置等,类似于OpenAI的操作界面。

- 支持与安全:它们提供与OpenAI或Claude类似的支持与安全性。

- 费用与订阅:这些工具是免费的,无需每月订阅。而像OpenAI这样的云服务每次API请求都需要付费。使用本地LLM可以节省成本。

- 离线支持:无需网络连接即可加载和运行大型语言模型。

- 连接性:有时连接云服务如OpenAI可能信号不佳,本地运行则不受此影响。

六款最佳的本地LLM工具

根据具体使用场景,可以选择以下几款离线LLM应用程序。有些工具完全免费用于个人和商业用途,另一些可能需要为商业使用提出申请。以下是适用于Mac、Windows和Linux的六大最佳工具。

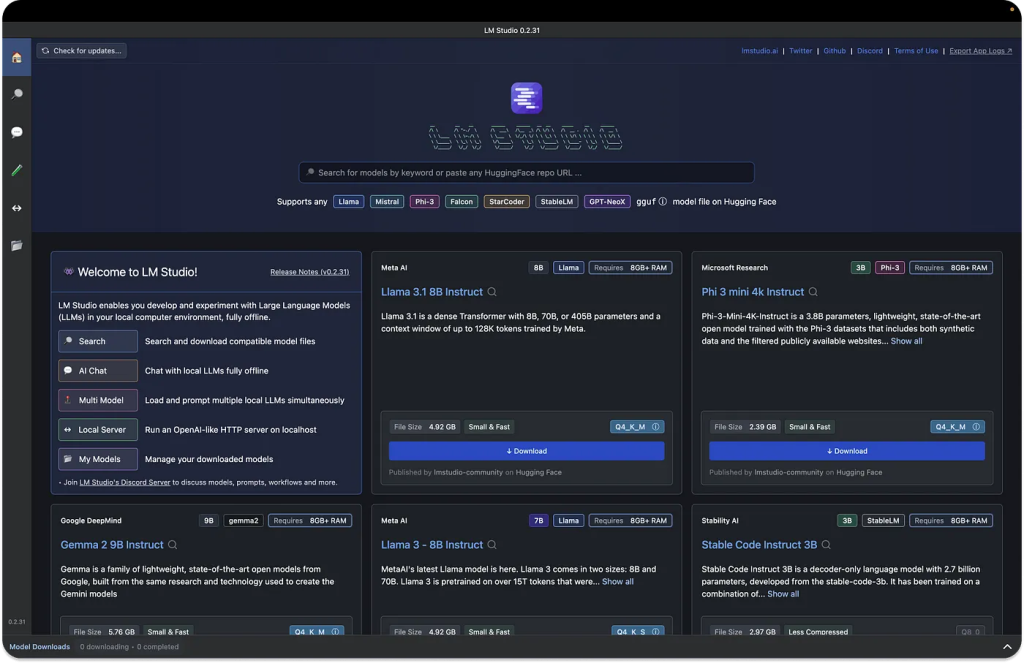

1. LM Studio

LM Studio可以运行任何gguf格式的模型文件,支持来自Llama 3.1、Phi 3、Mistral和Gemma等提供商的模型文件。下载应用程序后,LM Studio会展示顶级LLM供下载测试,还可以通过搜索栏筛选特定模型。

LM Studio主要功能

- 模型参数自定义:可以调整温度、最大token数量、频率惩罚等参数。

- 聊天记录:保存对话记录供以后使用。

- 参数提示:可以悬停在信息按钮上查看模型参数和术语解释。

- 跨平台支持:支持Linux、Mac和Windows操作系统。

- 机器规格检查:检查GPU和内存等计算机规格,并提供兼容的模型下载建议。

- AI聊天与实验场:可以与多个LLM同时进行多轮对话,测试多个模型。

- 本地推理服务器:开发者可以设置类似OpenAI API的本地HTTP服务器。

使用LM Studio的好处

免费用于个人用途,无需API密钥即可连接OpenAI的Python库。支持在一台设备上运行多个模型,并提供美观易用的界面。

# Example: reuse your existing OpenAI setup

from openai import OpenAI

# Point to the local server

client = OpenAI(base_url="http://localhost:1234/v1", api_key="lm-studio")

completion = client.chat.completions.create(

model="TheBloke/Mistral-7B-Instruct-v0.1-GGUF",

messages=[

{"role": "system", "content": "Always answer in rhymes."},

{"role": "user", "content": "Introduce yourself."}

],

temperature=0.7,

)

print(completion.choices[0].message)2. Jan

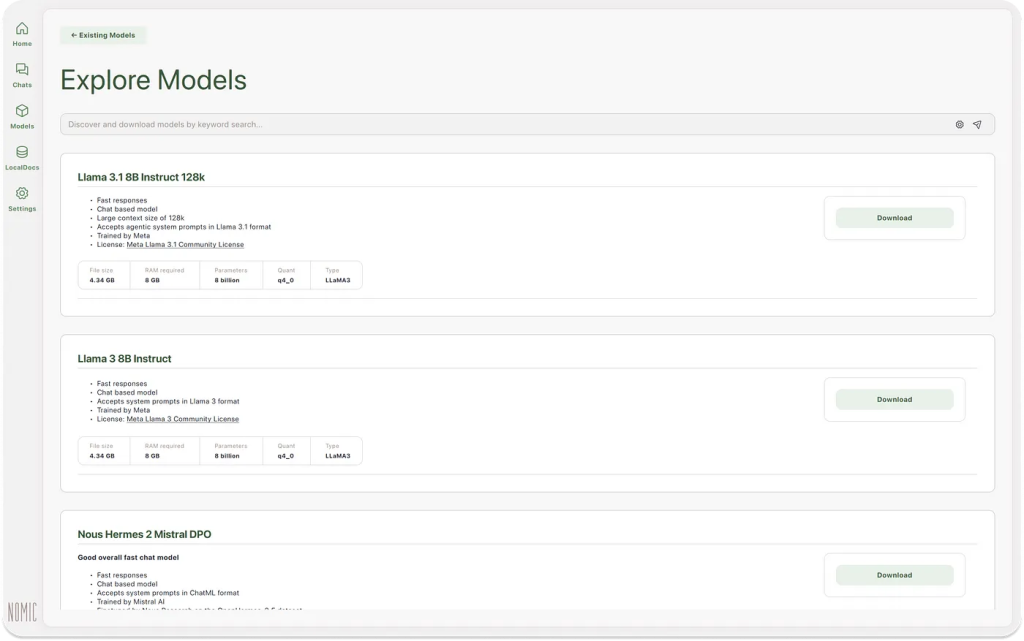

Jan是一个开源的ChatGPT版本,专为离线使用而设计。它允许用户在不连接网络的情况下运行Llama或Mistral等流行模型,还可以连接远程API如OpenAI。

Jan主要功能

- 本地运行:可在设备上离线运行AI模型。

- 内置模型:下载后可以直接使用已安装的模型。

- 模型导入:支持从Hugging Face导入模型。

- 自定义推理参数:调整最大token、温度、流式传输等推理参数。

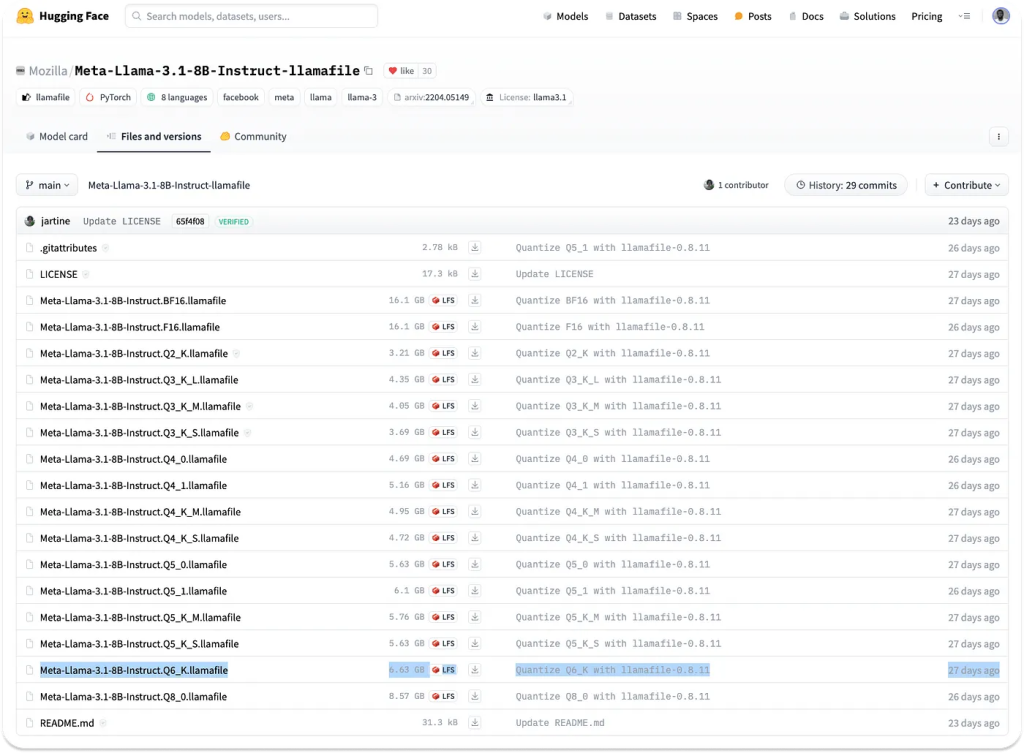

3. Llamafile

Llamafile由Mozilla支持,旨在通过快速的CPU推理和无需网络访问的方式让AI变得更为普及。它将LLM转换为多平台的可执行文件格式(ELF)。

Llamafile主要功能

- 可执行文件:只需一个可执行文件即可运行LLM。

- 模型文件转换:支持将流行模型格式如.gguf转换为.llamafile格式。

使用Llamafile的好处

完全离线运行,适合需要快速处理长文本和大文档的场景。

4. GPT4ALL

GPT4ALL以隐私和安全为核心设计,不需要互联网即可运行LLM。它支持Mac、Windows和Ubuntu。

GPT4ALL主要功能

- 隐私优先:确保所有对话和提示数据仅保存在本地机器上。

- 完全离线:无需互联网连接即可运行。

- 企业版支持:提供企业版,包含安全性、支持和设备许可。

5. Ollama

Ollama允许用户无需连接API即可轻松创建本地聊天机器人,支持大量模型库,且无需支付订阅费用。

Ollama主要功能

- 模型自定义:支持转换.gguf模型文件并运行。

- 模型库:提供大量模型供试用和下载。

- 移动集成:通过SwiftUI等应用将Ollama带到iOS和macOS平台。

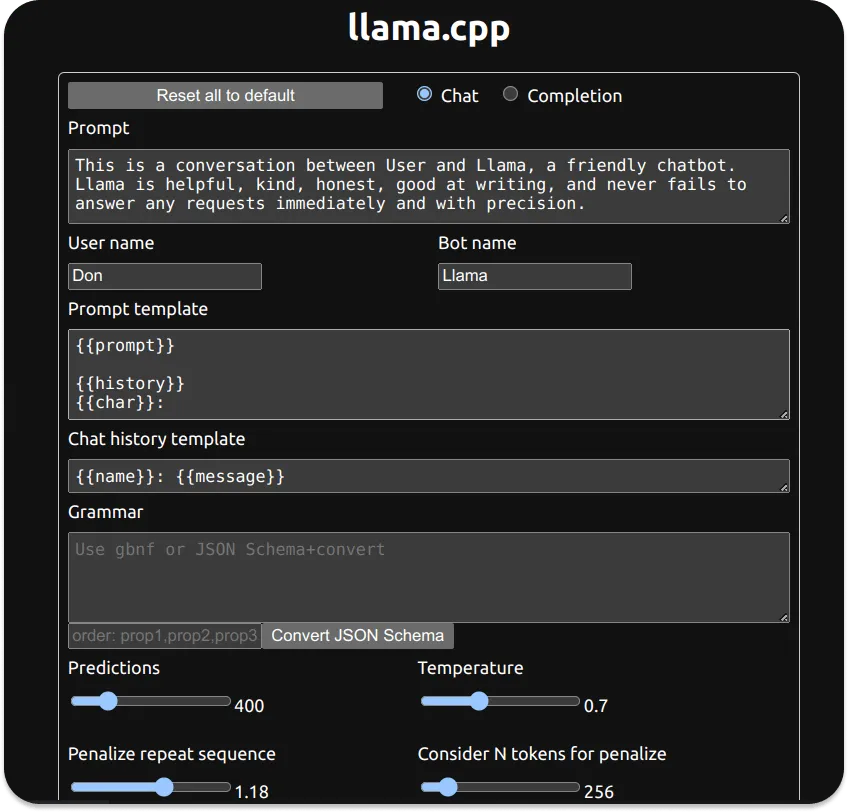

6. LLaMa.cpp

LLaMa.cpp是众多本地LLM工具(如Ollama)的底层技术,支持在各种硬件上进行高效的本地推理。

LLaMa.cpp主要功能

- 简单设置:只需一条命令即可安装。

- 性能优秀:在各种硬件上表现出色,支持多个流行的LLM模型。

本地LLM的应用场景

本地运行LLM适合需要更高隐私性、不便联网或信号不佳的场景。例如,在远程医疗环境中,可以离线处理患者文档,避免上传到任何AI API。

结论

选择并使用本地LLM工具有多种优势,不仅可以节省费用,还能确保数据隐私。在如LLM Studio和Jan这样的图形用户界面工具中,开发者无需订阅服务即可配置和实验LLM模型。而命令行工具如Ollama和LLaMa.cpp则适合那些希望深入研究和测试模型的用户。