研究人员近期提出了一项新方法,名为“Soft Thinking(柔性思维)”,旨在打破大型语言模型(LLM)基于离散语言符号进行推理的限制,首次尝试将人类类比式、抽象化的思维模式引入语言模型推理机制中。这一方法由加州大学圣塔芭芭拉分校、加州大学圣克鲁兹分校、加州大学洛杉矶分校、普渡大学、LMSYS组织及微软的研究团队联合提出。

人类推理往往并不依赖于词语,而是在尚未形成具体语言表述前就能并行处理多个抽象概念。然而当前的语言模型仍局限于“逐词输出”的模式,即模型每次只能在一个预定义词汇表中选择一个词元(token)。这种标准链式思维(Chain-of-Thought, CoT)方法迫使模型每一步都必须做出明确决策,导致在面对模糊性、复杂性问题时难以灵活应对。

Soft Thinking 提出了一种新的推理方式,允许模型在“连续概念空间”(continuous concept space)中进行推理,即通过“概念词元”(concept tokens)来表达思维路径。这些概念词元是对整个词汇嵌入空间的概率加权组合,而非某个具体词元的单点选择。通过这种方式,模型可以并行探索多个推理方向,更接近人类的模糊性认知过程。

值得注意的是,这一方法不需要对现有模型进行再训练或结构性修改,仅通过操作模型在推理过程中的中间表示(embedding)即可实现。为提高效率,Soft Thinking 引入了一种称为“Cold Stop”的机制,当模型对当前推理路径的置信度足够高时,自动终止推理过程,从而减少不必要的计算。

在理论层面,该方法被证明可通过线性近似方式,对所有可能推理路径进行边缘化处理,即同时评估所有路径的加权结果。实验证明,这种方式在保持计算可控的同时,显著提升了推理表现。

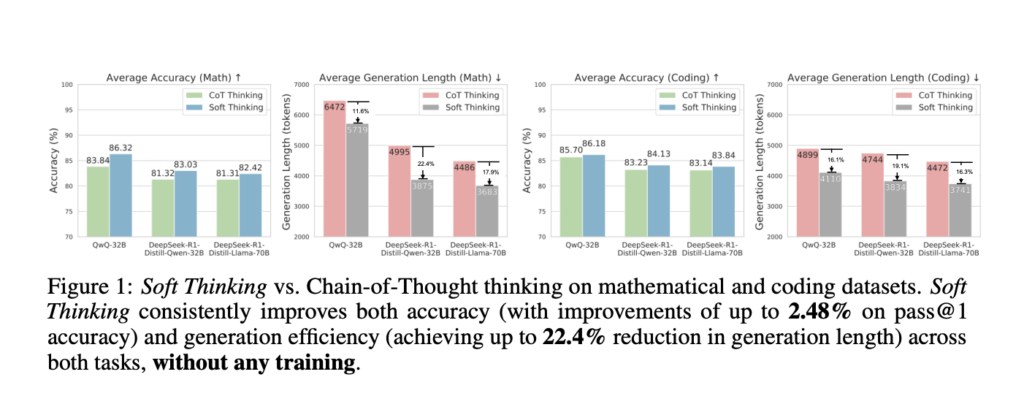

具体评估方面,研究团队使用三种不同规模和架构的开源LLM,在八项数学与编程任务基准上对Soft Thinking进行了测试。结果显示,该方法较标准CoT和贪婪型CoT推理方法在准确率(Pass@1)提升最多2.48%,而所需的生成词元数量则减少高达22.4%。这不仅表明模型推理更准确,也更加高效。

此外,由于该方法在不更改模型参数的情况下实现了性能提升,Soft Thinking 被认为具有良好的通用性与工程落地潜力,可广泛应用于现有的大模型推理流程中。其开源代码已对外发布,便于开发者和研究人员进一步探索和优化。

总结来看,Soft Thinking是一种无需训练的推理机制创新,它用概念词元替代传统离散词元推理,使大型语言模型能在连续空间中进行并行、多路径的推理。这一方法既提升了推理准确性,也显著提高了效率,且不牺牲模型可解释性。未来研究可进一步探索该方法在分布外输入、极端不确定性场景中的稳健性,并尝试通过训练优化其表现。