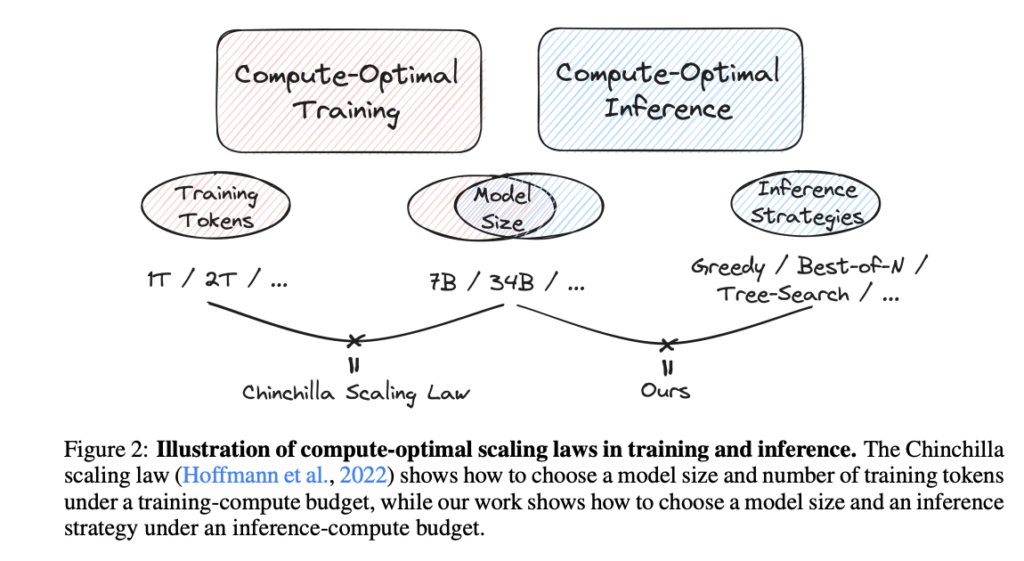

大语言模型(LLMs)的成功得益于其扩展规律,揭示了模型规模、训练计算量与性能之间的关系。然而,尽管模型扩展取得了显著进展,对推理阶段计算资源如何影响训练后的性能仍缺乏深入理解。这种复杂性在于如何在提高性能与推理计算成本之间找到平衡。特别是,推理策略需要在性能提升和资源消耗之间做出权衡,以实现更高效的推理机制。

推理策略的发展现状

当前对LLM推理策略的研究涵盖了从数学推理到问题解决能力的各个方面。例如,逐步生成解决方案的方法已被拓展为包括解答验证和排名的多层次流程。推理策略从贪婪解码和束搜索等确定性方法,发展到引入多样性生成的动态采样算法。更高级的策略包括多数投票、加权多数投票,以及如蒙特卡洛树搜索(MCTS)等基于搜索的算法。此外,过程奖励模型(Process Reward Models,PRMs)也越来越受关注,利用奖励机制指导多步推理过程。

跨机构研究的最新进展

清华大学跨学科信息科学研究所和卡内基梅隆大学计算机科学学院的研究团队,对推理扩展规律与计算最优推理策略进行了全面研究。他们聚焦于模型规模与推理生成过程之间的关键权衡,分析不同推理方法的性能与成本关系。这项研究表明,借助高级推理算法,小型模型可以在成本和性能方面超越大型模型,这一结论挑战了传统的模型扩展与效率认知。

研究测试了多种推理策略,包括贪婪搜索、多数投票、最佳n选项、加权投票,以及两种树搜索算法。结果表明,小型模型结合先进推理方法时,其效率甚至优于单纯扩展模型规模的策略。

实验设计与关键发现

研究围绕两个核心问题设计实验,探索数学问题解决中的计算最优推理策略。选取了MATH和GSM8K两个数学数据集,采用多个政策模型,包括Pythia模型、专门的数学模型Llemma,以及Mistral-7B。所有实验均使用一个一致的Llemma-34B奖励模型,对基于Math-Shepherd合成数据集的解决方案质量进行评估。通过多次重复实验,确保数据统计结果的稳健性和可靠性。

重要发现:

- 小模型的优势:

Llemma-7B的推理准确度几乎与Llemma-34B相当,但计算资源消耗减少了50%。这表明,通过适当的推理策略,小型模型在成本与性能上具备显著优势。 - REBASE方法的卓越表现:

REBASE树搜索方法在多个实验设置中展现了Pareto最优性能,不仅超越了采样法和传统树搜索(如MCTS),还实现了更高的准确性,同时显著降低了计算预算。 - 传统采样法的局限性:

研究指出,多数投票等采样策略存在固有缺陷,在计算效率和性能提升方面受到限制。

结论与未来研究方向

这项研究为LLM的计算最优推理策略提供了三大关键结论:

- 小型模型配合复杂推理算法,可在有限计算资源下超越大型模型。

- 传统采样法(如多数投票)存在基本性能瓶颈,不适合高效推理需求。

- REBASE树搜索作为新兴推理方法,展现了跨预算的最优性能,挑战了传统推理算法的复杂性假设。

研究的局限性在于其重点集中于数学问题求解。未来研究可探索推理扩展规律在多领域任务中的适用性,从而推动LLM在更广泛应用中的推理效率优化。