Meta 宣布了其最新的生成式 AI 模型——Llama 家族的新成员:Llama 3.3 70B。 https://huggingface.co/meta-llama/Llama-3.3-70B-Instruct

在 X 平台的发布帖子中,Meta 生成式 AI 副总裁 Ahmad Al-Dahle 表示,Llama 3.3 70B 尽管参数更小,但性能已经达到 Meta 最大模型 Llama 3.1 405B 的水平,且成本更低。

他写道:“通过利用最新的后训练技术,这款模型显著提升了核心性能,同时大幅降低了使用成本。”

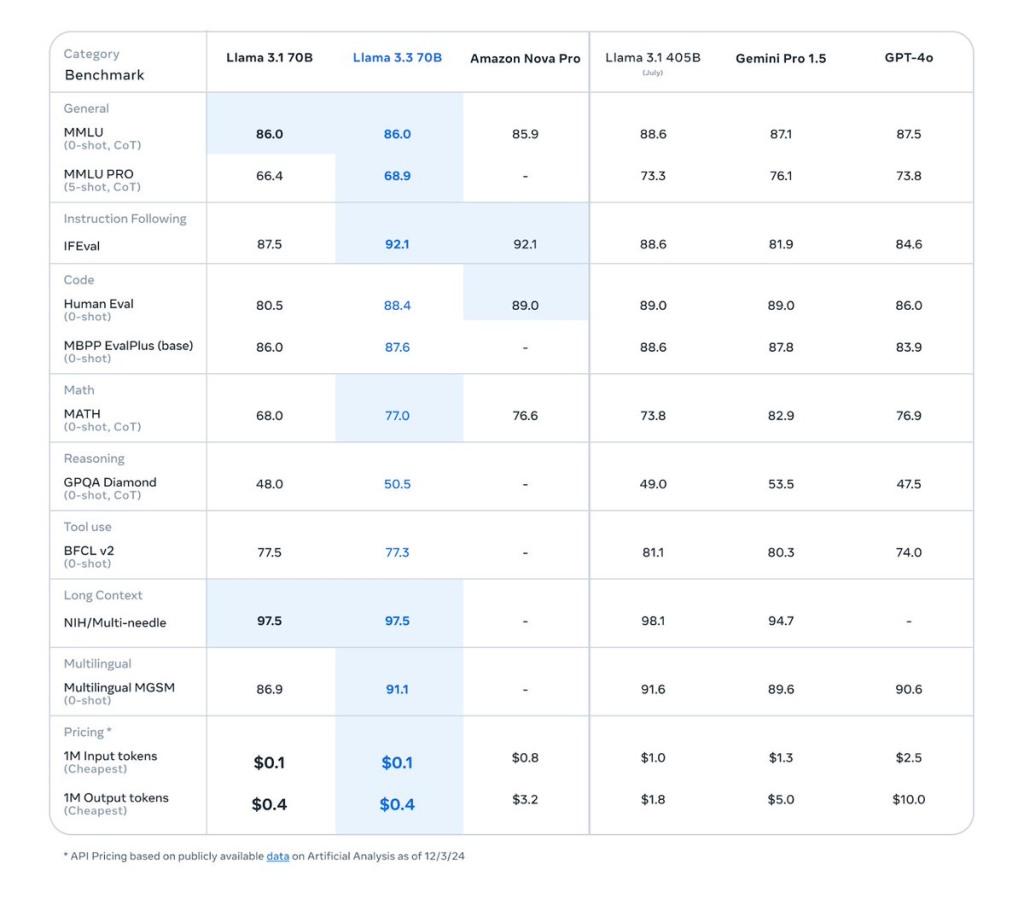

Al-Dahle 还分享了一张对比图,显示 Llama 3.3 70B 在多项行业基准测试中表现优异,包括 MMLU(评估语言理解能力的测试)。这款模型在数学、通识知识、指令执行以及应用程序操作等方面都实现了性能升级。据 Meta 发言人介绍,Llama 3.3 70B 可从 AI 开发平台 Hugging Face 以及 Llama 官方网站下载,适用于多种商业和非商业用途。

开放与限制并存

Meta 一直致力于通过“开放”模型来占据 AI 领域的领先地位,Llama 系列成为其核心战略之一。尽管 Llama 并非完全开放,例如每月用户超过 7 亿的平台需申请特殊许可证,但这并未阻碍其发展。截至目前,Llama 模型累计下载量已超过 6.5 亿次。

同时,Llama 的“开放性”也带来了一些争议。此前有报道称,中国军方研究人员使用 Llama 模型开发了一款国防聊天机器人。对此,Meta 回应称已将 Llama 模型提供给美国国防承包商以应对类似问题。此外,Meta 在应对欧盟 AI 法案(AI Act)和 GDPR(《通用数据保护条例》)方面也面临压力。例如,GDPR 要求 Meta 停止使用未经同意的欧洲用户数据训练 AI 模型,这迫使公司暂停了部分训练计划。

尽管如此,Meta 在内部依然广泛应用了 Llama 模型。公司 AI 助手 Meta AI 由 Llama 提供支持,目前月活跃用户已接近 6 亿。CEO 马克·扎克伯格表示,Meta AI 有望成为全球最常用的 AI 助手。

加速基础设施升级

为了支撑 Llama 的快速迭代,Meta 正全力扩充计算基础设施。本周三,公司宣布将在路易斯安那州建设一座耗资 100 亿美元的 AI 数据中心,这是 Meta 史上最大规模的数据中心。

扎克伯格在今年 8 月的第四季度财报电话会议上透露,为训练下一代 Llama 4 模型,计算需求将是 Llama 3 的 10 倍以上。为此,Meta 已采购超过 10 万块 Nvidia GPU,以支持其模型开发,与 xAI 等竞争对手展开资源较量。

然而,生成式 AI 模型的开发成本高昂。据统计,Meta 的资本支出在 2024 年第二季度激增 33%,达到 85 亿美元,主要用于服务器、数据中心和网络基础设施。显然,Meta 正以巨大的投入巩固其在 AI 领域的地位,同时为未来的大模型竞争做好准备。