法国人工智能实验室Mistral AI近日发布了Small 3,一款24B参数的大型语言模型(LLM),号称是**“同类中最优”的高效模型,并且优化了延迟表现。Mistral AI表示,该模型可以与Llama 3.3 70B、Qwen 32B等大模型竞争,甚至可以作为GPT-4o mini的开源替代方案**。

小巧但强大,Small 3为何值得关注?

1. 开源+本地运行,MacBook也能带得动

Small 3完全开源,采用Apache 2.0许可证发布,任何个人或企业都可以使用和修改。更值得一提的是,它可以在拥有32GB RAM的MacBook上本地运行,意味着开发者和企业无需昂贵的云计算资源,也能高效利用AI能力。

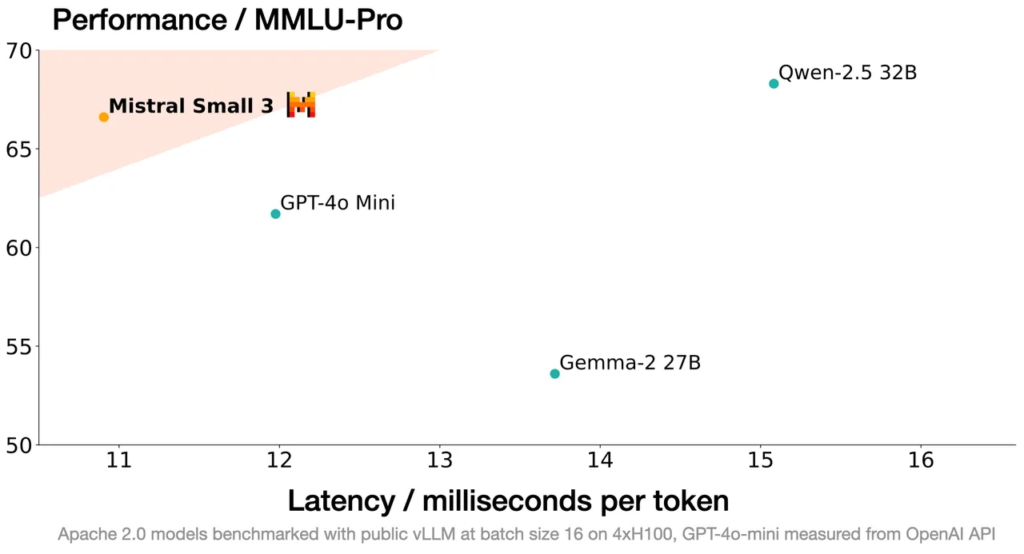

2. 高效低延迟,适合关键任务

Mistral AI表示,Small 3专门优化了延迟表现,尤其适用于需要快速、精准响应的场景。其架构采用较少的层数,提升了处理速度,同时仍保持卓越的推理能力。在MMLU基准测试中,Small 3的准确率超过81%,展现了强大的通用知识理解能力。

3. 训练方式不同,更具灵活性

有别于其他大模型,Small 3未经过强化学习(RL)或合成数据训练,Mistral AI认为,这让Small 3在模型生产过程中处于较早阶段,比DeepSeek R1等模型更具可塑性。此外,该模型指令微调版本的表现甚至可媲美参数量大三倍的开放权重模型,并且在代码、数学、通识知识和指令跟随能力上,与GPT-4o mini不相上下。

用户评价如何?

Mistral AI通过第三方供应商进行了一项人类评估测试,使用超过1000个编码和通识问题对Small 3进行考验。测试结果显示,大多数评审者更喜欢Small 3,相较于Gemma-2 27B和Qwen-2.5 32B表现更优,但在对比Llama-3.3 70B和GPT-4o mini时,评价则相对平均。这表明Small 3在不同应用场景下可能具有不同的优势。

适用场景:从虚拟助理到金融风控

Mistral AI推荐使用Small 3来构建客户服务型虚拟助手,尤其适用于金融欺诈检测、法律咨询、医疗健康等高精度需求场景。该模型还能用于机器人、制造业等领域,甚至非常适合爱好者和企业在本地环境中处理敏感或专有信息。

此外,Mistral AI暗示,未来几周内将推出更多不同规模、推理能力更强的模型,敬请期待!目前,Small 3已可在HuggingFace上获取。https://huggingface.co/mistralai/Mistral-Small-24B-Instruct-2501