Mistral AI正式推出Magistral系列,这是该公司迄今为止最具推理能力的大语言模型(LLM)套件,标志着LLM能力发展的重要跃迁。该系列包括两个版本:Magistral Small,一个拥有240亿参数、遵循Apache 2.0许可证的开源模型;以及Magistral Medium,一个专为企业级应用设计的专有版本。此次发布强化了Mistral在全球AI版图中的地位,重点聚焦“推理时间”性能优化这一LLM设计的前沿方向。

Magistral系列体现了从“参数规模优先”到“结构化推理优先”的根本性转变。无论是开源版本Magistral Small,还是企业部署向的Magistral Medium,两者均采用链式思维(Chain-of-Thought, CoT)微调技术,支持逐步生成中间推理步骤。这一策略大幅提升了模型在多步推理任务中的准确性、可解释性和稳健性,尤其适用于数学运算、法律分析及科学问题求解等场景。

Magistral Small在语言能力方面也表现突出,原生支持包括法语、西班牙语、阿拉伯语和简体中文在内的多种语言。相较于其他以英语为中心的大语言模型,该模型展现出更强的全球适应性,使其在多语言、跨文化应用中具备天然优势。

在部署策略上,Mistral采取“开源+专有”的双轨发布路径:Magistral Small完全开放,遵循Apache 2.0许可证,已在Hugging Face平台上线,适用于研究、定制和商业化部署;而Magistral Medium则聚焦企业级场景,通过Mistral的云平台和API进行部署,具备更强的吞吐能力和实时响应表现,专为延迟敏感型生产环境而设计。

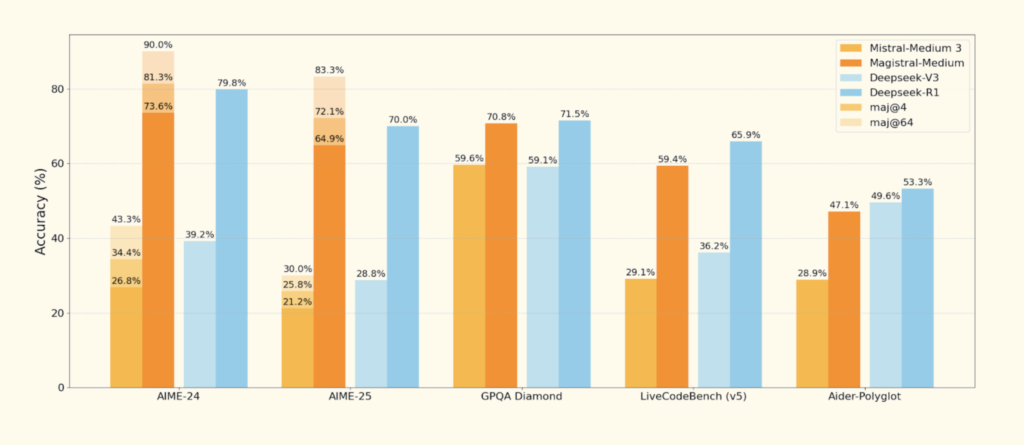

性能方面,根据Mistral内部评估,Magistral Medium在AIME2024基准测试中准确率达到73.6%,通过多数投票策略进一步提升至90%;Magistral Small表现也不俗,准确率达70.7%,多数投票后上升至83.3%。这些成绩已使Magistral系列跻身于当今前沿LLM之列,具备与GPT-4、Claude 3等顶级模型抗衡的实力。

Magistral Medium在吞吐与响应速度上的表现也十分亮眼,其推理速度可达每秒1000个token,适用于高并发、大规模企业系统。这一性能提升得益于Mistral自研的强化学习(RL)微调流程以及高效的解码策略。与市面上大多采用通用RLHF模板的模型不同,Magistral采用自定义的“推理语言对齐”(Reasoning Language Alignment)机制,以显式方式引导推理路径生成,确保输出逻辑一致性。这一机制也与Mistral基础模型系列的指令微调、代码理解和函数调用原语保持兼容,提升了整体系统的可扩展性。

此次发布也在行业中产生深远影响。凭借强大的推理能力和多语言支持,Magistral系列特别适合部署于对解释性与可追溯性要求极高的领域,如医疗保健、金融服务与法律科技等受监管行业。在这些领域,系统的稳定性、可控性与准确性是业务决策中不可或缺的要素。Magistral通过结构化推理方式,能有效降低“黑箱输出”风险,为关键行业提供透明且可验证的AI解决方案。

值得注意的是,Mistral并未简单追求参数膨胀,而是从“推理时间效率”出发设计模型,使其在无需依赖超大算力资源的情况下依然具备强大能力,顺应当前全球范围内对“高效低耗”模型日益增长的需求。

从战略角度来看,Magistral的“双版本”路径也体现出Mistral对生态构建与市场覆盖的深度思考。一方面,通过Magistral Small激发研究界与开发社区的参与与创新;另一方面,通过Magistral Medium提供企业级服务能力与商业化落地保障。这种模式类似于基础软件平台的双重路径,比如Linux内核与企业版Red Hat系统的并行演进模式,极大提高了平台的适应力与延续性。

随着Magistral系列即将在MMLU、GSM8K、Big-Bench-Hard等标准公开基准上亮相,其实际竞争力将在更广泛环境中得到全面验证。目前已公布的内部评测数据令人期待,而后续的公开对比将成为其市场接受度与技术定位的重要参考。

展望未来,Magistral不仅是一款新型语言模型,更代表Mistral AI在AI全球格局中的一次战略发声。它在技术维度上强调“推理质量”,在市场维度上体现“开放与闭源并重”,在产品维度上主打“高效可控”,在行业维度上推进“跨语境落地”。在“推理成为AI核心差异化要素”的背景下,Magistral提供了一种极具现实可行性的替代方案。

Magistral系列的推出,不仅是Mistral迈向AI领导力的一次突破,也是欧洲AI技术在全球科技格局中的一次集体进击。它象征着大语言模型进入新阶段的开始——推理为王,效率为本,多语共存,开放共赢。