近年来,OpenAI 一直陷在各种版权纠纷中——作家、程序员、还有各路创作者轮番控诉,说自家的书、代码、文章,全都被拿去“喂养”AI 模型,却连个招呼都没打。OpenAI 则摆出“合理使用”这张老牌挡箭牌,但原告们可不买账,认为美国版权法里根本没有这种为 AI 训练开的小灶。

这项研究由华盛顿大学、哥本哈根大学和斯坦福大学的研究团队联合操刀,主打的就是一个新方法,用来判断 AI 模型到底有没有把训练数据“背”下来。研究特别针对那种通过 API 使用的模型,比如 OpenAI 家的产品。

众所周知,大模型其实就是“预测引擎”,靠吞海量数据找规律,从而能写文案、画图、答题样样通。虽然大多数生成结果都不是复制粘贴原文,但模型的“学习方式”决定了,它们难免会漏出点“原汁原味”的内容。比如图像模型被发现能“吐出”电影截图,语言模型则时不时冒出和新闻文章一模一样的段落。

研究团队这次的核心操作是:找出“高惊讶度”词汇。简单说,就是那些出现在句子里、却不太常见的词,比如“Jack 和我静静地坐着,雷达发出嗡嗡声”这句话中的“雷达”,就比“引擎”或“收音机”更不寻常,更容易被当作“记住了”的标志。

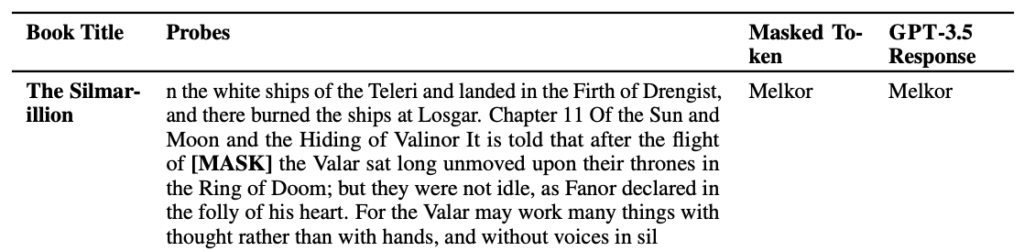

研究者用这些“高惊讶度”词汇构造了测试题,专门拿 GPT-4 和 GPT-3.5 来试水。他们从小说和《纽约时报》的文章里抽出句子,删掉高惊讶度的词,然后让模型来猜。如果模型猜得又快又准,说明它八成在训练中“眼熟”这些句子。

测试结果令人咋舌:GPT-4 显然“记住”了不少热门小说的片段,特别是那些来自一个叫 BookMIA 的受版权保护电子书合集。同时,《纽约时报》的文章也没能幸免,虽然模型记住的比例低一些,但依然存在。

华盛顿大学的博士生、研究联合作者 Abhilasha Ravichander 向媒体透露,这项发现正是要揭开大型模型训练数据的“谜团”。她直言:“想要真正值得信赖的大模型,就得能科学地审查它们。”这项研究就是为“数据透明化”铺路的第一步。

与此同时,OpenAI 也一直呼吁放宽 AI 使用版权内容的限制。他们虽然签了部分内容授权协议,也提供“退出机制”供版权方说不,但这家公司仍在积极游说政府,希望把 AI 训练纳入“合理使用”保护伞之下。

一句话总结:大模型记不记得你写的那本书?现在终于有人能测出来了。