概述

适应性是自然界最引人注目的现象之一。章鱼通过改变皮肤颜色与环境融为一体,大脑在受伤后重塑神经网络恢复功能,这些能力让生命体在多变的环境中茁壮成长。

在人工智能领域,适应性的概念同样令人瞩目。一个能够动态调整自身权重的机器学习系统,可以在陌生环境中不断学习并展现进化能力,这种特性接近于生命体的智能表现。自适应AI不仅提升效率,也为构建持续学习的模型提供了新的可能性。

研究团队提出了Transformer²,一种能够根据任务需求动态调整自身权重的机器学习系统。这一系统通过两步流程分析任务需求并进行权重调整,不仅在效率上超越了传统方法如LoRA,还显著提升了在多种任务上的表现,同时大幅减少了参数需求。

解剖LLM的“脑”

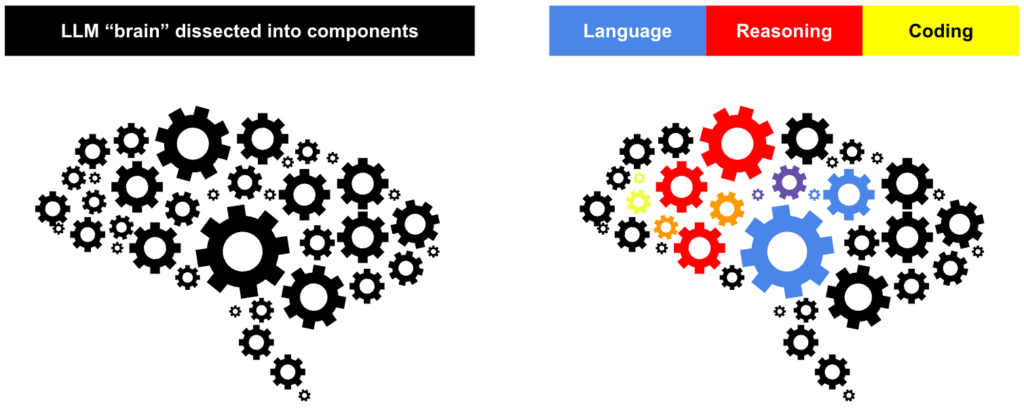

大型语言模型的知识储存在权重矩阵中,这些矩阵如同人类大脑的神经网络,是模型处理信息和解决任务的核心。为了让这些“脑”适应新任务,研究团队利用奇异值分解(SVD)对其内部结构进行解析。

SVD将LLM的复杂知识分解为更小、更独立的组件,例如数学能力、语言理解能力等。研究表明,通过增强关键组件的信号并抑制其他组件,可以提升模型在不同任务上的表现。

Transformer² 的工作原理

Transformer² 提出了自适应LLM的新方法,通过动态调整权重矩阵的关键组件来重新定义任务处理方式。在训练阶段,系统使用奇异值微调(SVF)方法结合强化学习,增强或抑制特定组件的信号,从而优化模型在不同任务中的表现。在推理阶段,模型通过三种任务检测方法调整权重,完成自适应过程。

- 基于Prompt的适应,通过特定设计的Prompt分类任务并选择预训练的z向量。

- 基于分类器的适应,利用SVF训练的分类器识别任务类型并选择合适的z向量。

- 少样本适应,通过加权插值结合多个z向量,利用优化算法调整权重以适应少样本任务。

这种两步流程确保了系统在多种场景中的鲁棒性和高效性。

SVF的核心优势

在训练阶段,SVF学习了一组z向量,每个任务对应一个z向量。这些z向量如同任务专家,控制权重矩阵中各组件的影响力。例如,在数学任务中,z向量可能突出与数学相关的组件,而抑制其他不相关的部分。

研究团队通过强化学习训练这些z向量,使得Transformer²能够以最少的额外参数适应新任务。

主要实验结果

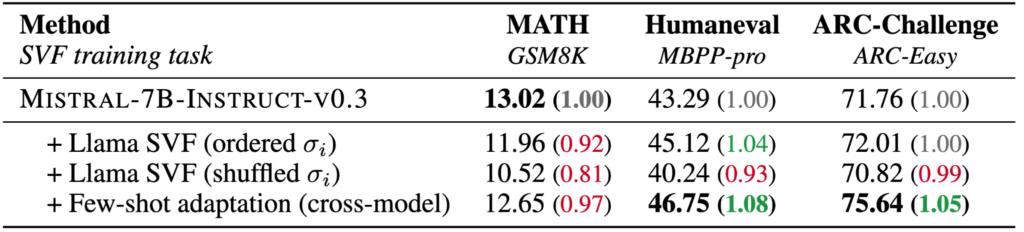

团队在Llama和Mistral模型上验证了Transformer²的性能,任务范围涵盖数学、代码、推理和视觉问答等领域。结果表明,与LoRA相比,SVF在文本任务上表现更优,尤其在数学任务中表现出色。这得益于强化学习无需每个问题的“完美解答”,而是通过更灵活的优化目标提升性能。

在未见任务上的测试显示,随着方法复杂性的增加,系统的性能也显著提升。例如,在数学问题中,系统通过结合数学、编程和逻辑推理能力,实现了跨领域的综合表现。研究还发现,将Llama训练的z向量迁移到Mistral模型后,后者在大多数任务上的表现有所提高,这暗示了跨模型知识共享的潜力。

未来展望

Transformer² 展现了AI系统发展的重要里程碑,其动态适应新任务的能力表明,自适应LLM有望彻底改变AI的研究和应用方式。未来,AI系统可能不再是固定工具,而是能够持续学习、进化和适应的新型智能体。这种能力将助力跨领域问题的解决,为产业发展和日常生活提供全新动力。