在2023年11月,Stability AI首次向世界介绍了名为“Stable Video”的技术,将其模型代码上传至GitHub,同时在HuggingFace上发布了模型权重,以便用户能够下载并在配备相应硬件的本地环境中运行之。

然而,对于那些既没有强大图形处理单元(GPU)也缺乏配置所需环境技能的人群,他们该如何是好?幸运的是,Stability AI最近推出了它们的Stable Video网站,如今任何人仅需一个谷歌账户和一个网络浏览器,便能轻松尝试制作人工智能视频。

所谓的Stable Video Diffusion,是一个旨在为媒体、娱乐、教育及营销领域提供广泛视频应用解决方案的强大工具。它能够将文本和图像输入转换成生动的场景,把简单的想法变成电影级的体验。

这项技术以两种图像转视频模型的形式被释放到市场,能够生成14帧和25帧的视频,并允许用户在3到30帧每秒之间自定义帧率。

其能力范围涵盖:

- 视频时长:2至5秒

- 帧率:最高可达30帧每秒

- 处理时间:不超过2分钟

Stable Video Diffusion的工作原理依赖于一个复杂的过程,涉及扩散模型(Diffusion Models, DMs)、无分类器指导技术,以及专门为视频生成设计的基础模型架构。对于想深入了解其工作机制的人来说,可以参考该技术的白皮书。

在Stable Video网站上展示的社区生成的示例视频,包括了以“极光”、“非洲大象”及“深度场景中的动漫女孩操作太空穿梭机驾驶舱,伴随激光光影秀和反射镜面等元素的视频”为提示词的作品。

访问Stable Video的方式非常简单,只需使用谷歌账户登录其网站。在注册时,用户将获得150个免费积分,可以用于生成视频。

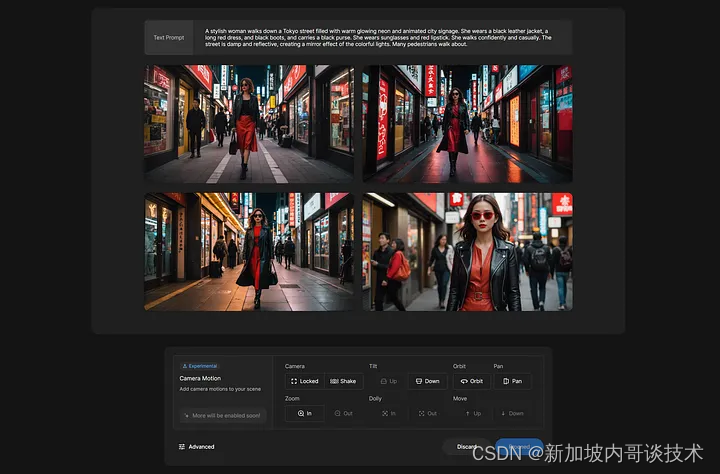

以一位穿着黑色皮夹克、长红裙和黑靴的时尚女士,在充满温暖霓虹灯和动态城市标志的东京街道上自信且悠然行走的场景为例,AI首先会生成四张图像,供用户选择其最喜欢的一张进行视频生成。

尽管其视频质量可能还不足以与Sora竞争,但已表现出相当不错的水平。

值得一提的是,使用文本提示生成视频将消耗11个积分,而使用图像输入每次生成则消耗10个积分。

对于新用户,Stability AI提供了150个免费积分的起始套餐。此外,用户还可以选择购买更多积分,以10美元购买500积分或50美元购买3000积分的价格,分别约可生成50个或300个视频。

然而,根据Stability AI提供的模型代码和权重的许可证及其可接受使用政策,这些视频目前仅限于研究和非商业用途。

总的来说,随着Stability AI在本周宣布另一种AI视频生成器的推出,过去一年里机器学习领域的进步速度令人赞叹。人们对于如何利用这项技术,尤其是在ControlNet得到适当适用于视频后的各种可能,充满了期待。尽管从稳定扩散生成稳定视频通常需要大量手动后期处理来消除闪烁,但有望在未来几次迭代后,其性能将与Sora相媲美。此外,对于有能力在本地运行模型的用户来说,10美元购买50个视频的价格或许显得有些高昂。